1 前言

deepseek安装

2 安装

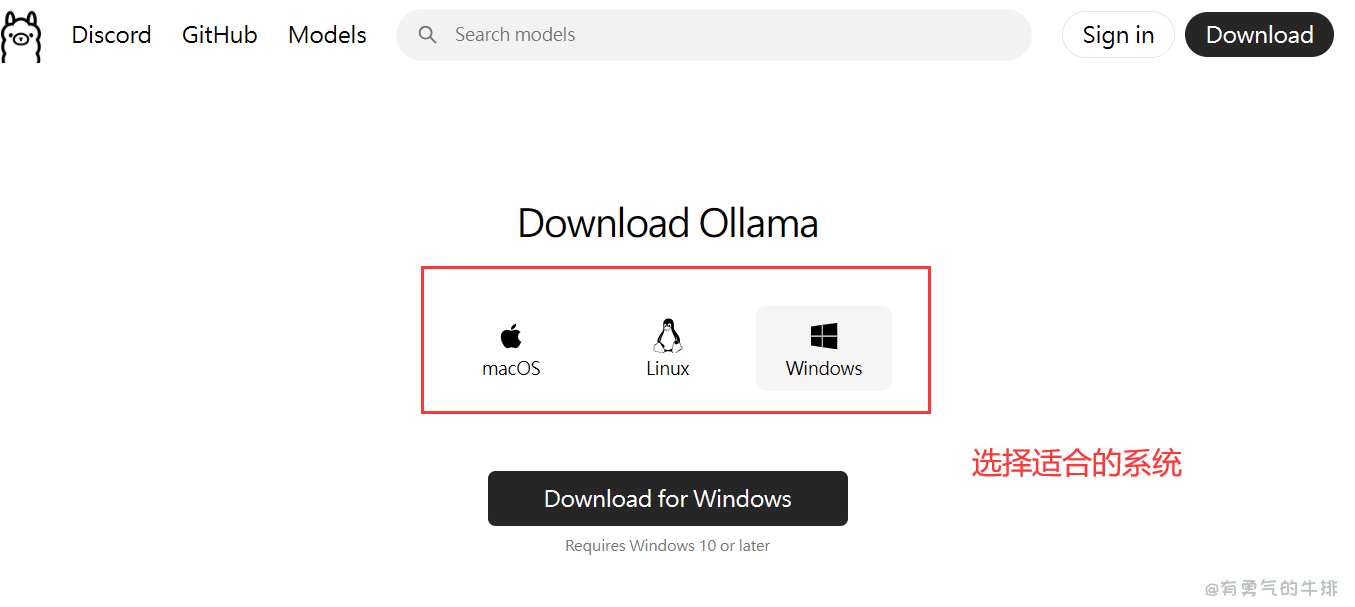

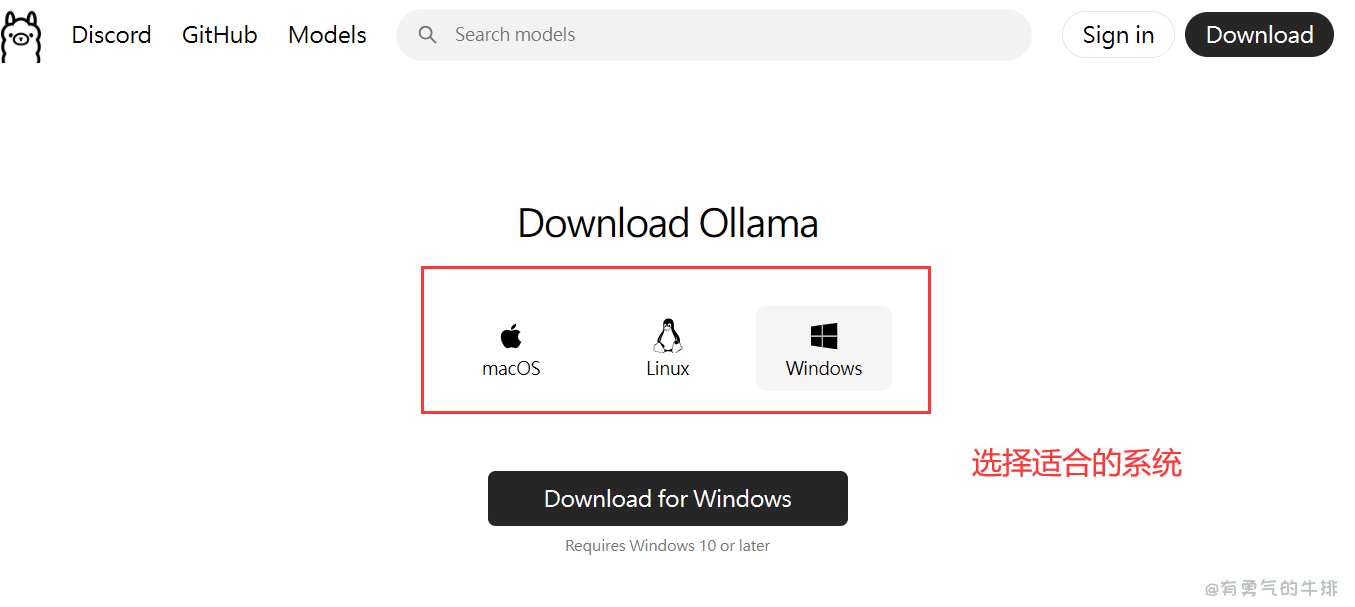

首先需要安装Ollama。

Ollama 是一个开源的 AI 平台,它通过提供高效的模型训练和推理支持,致力于简化 AI 应用的开发过程。Ollama 使得开发者能够在本地环境中运行高效的 AI 模型,无需依赖云端服务。它支持多种 AI 模型架构,提供简单的 API 来进行集成与部署。

https://ollama.com/download

2.1 windows安装

默认安装位置:C:\Users\XX\AppData\Local\Programs\Ollama

自定义安装路径

OLLAMA_MODELS: D:/my/ai

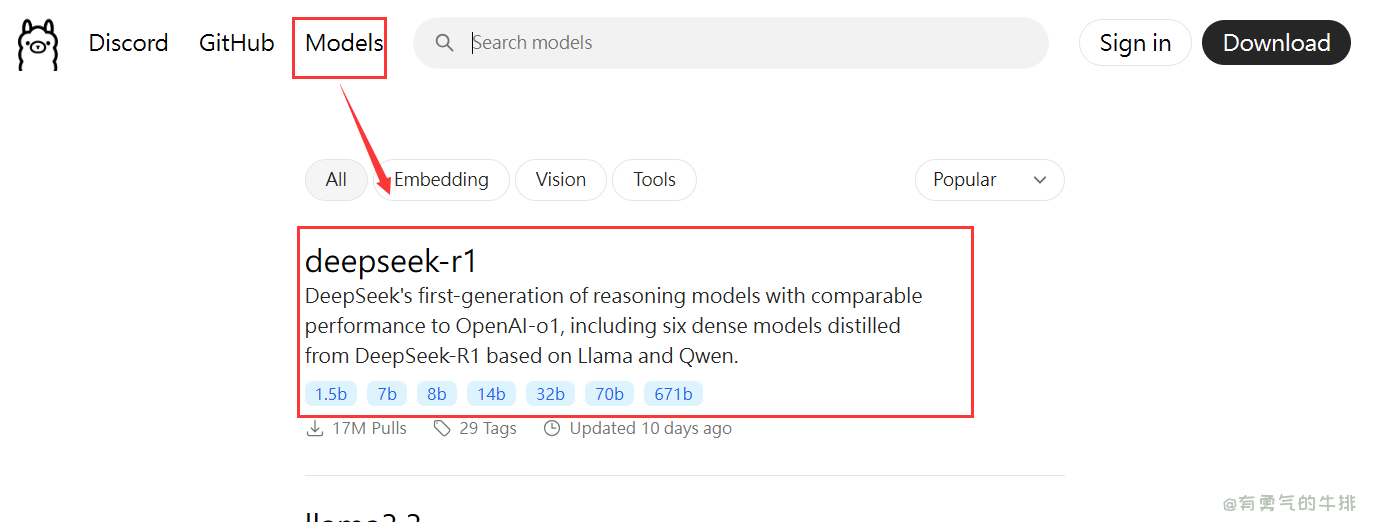

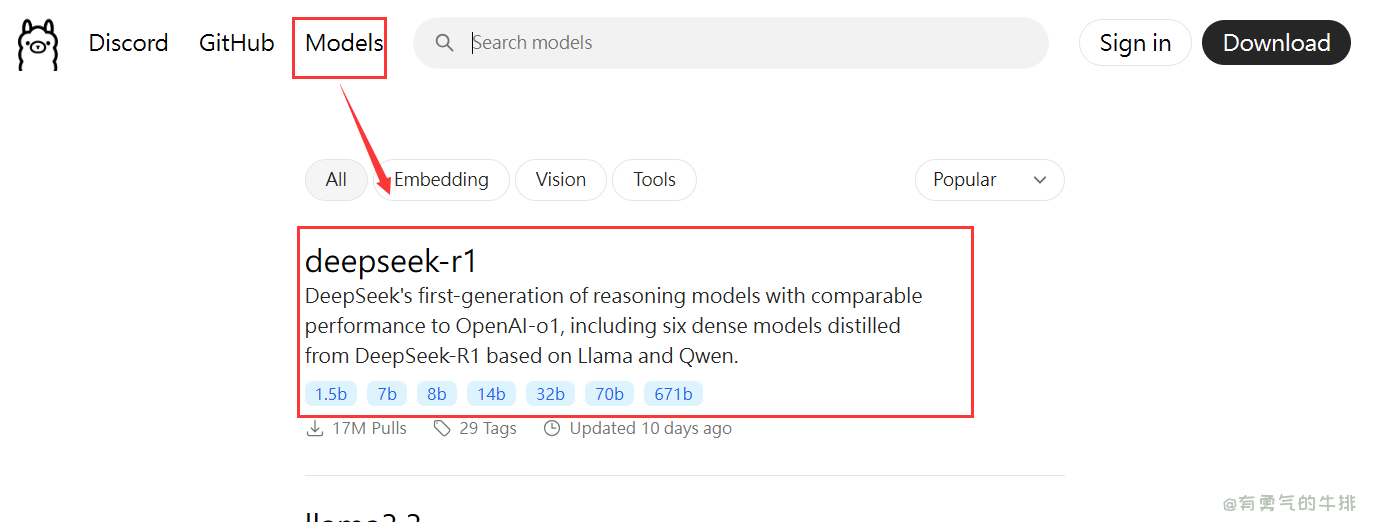

3 模型查询

https://ollama.com/search

4 模型安装

默认安装位置:C:\Users\用户名\.ollama\models

4.1 deepseek 1.5

启动命令,没有模型会自动下载。这里选择1.5b最小的参数。

ollama run deepseek-r1:1.5b

5 移动模型位置

(可选)先将模型手动剪切到目标为止,然后操作mklink。

mklink /J "C:\Users\Administrator\.ollama" "G:\ai\Ollama\models\.ollama"

6 配置API访问

6.1 windows配置

6.1.1 添加环境变量

OLLAMA_MODELS:G:\ai\Ollama

OLLAMA_HOST:0.0.0.0

OLLAMA_ORIGINS:*

6.1.2 配置防火墙

控制面板\系统和安全\Windows Defender 防火墙

高级设置->入站规则->新建规则->端口->下一步->TCP:11434->下一步->允许连接->下一步到命名

Allow Ollama Port 11434

检查进程

netstat -aon|findstr 11434

6.2 CentOS

Ollama的配置文件通常位于/etc/ollama/ollama.conf

listen_address = 0.0.0.0

7 常用命令

ollama serve 启动ollama

ollama create 从模型文件创建模型

ollama show 显示模型信息

ollama run 运行模型

ollama pull 从注册表中拉取模型

ollama push 将模型推送到注册表

ollama list 列出模型

ollama cp 复制模型

ollama rm 删除模型

ollama help 获取有关任何命令的帮助信息

curl http://192.168.56.1:11434/api/generate -d '{

"model": "deepseek-r1:1.5b",

"prompt": "为什么草是绿的?"

}'

windows

https://curl.se/windows/

curl http://localhost:11434/api/generate -d "{\"model\": \"deepseek-r1:1.5b\", \"prompt\": \"为什么草是绿的\"}"

<h2><a id="1__0"></a>1 前言</h2>

<p>deepseek安装</p>

<h2><a id="2__4"></a>2 安装</h2>

<p>首先需要安装Ollama。</p>

<p>Ollama 是一个开源的 AI 平台,它通过提供高效的模型训练和推理支持,致力于简化 AI 应用的开发过程。Ollama 使得开发者能够在本地环境中运行高效的 AI 模型,无需依赖云端服务。它支持多种 AI 模型架构,提供简单的 API 来进行集成与部署。</p>

<p><a href="https://ollama.com/download" target="_blank">https://ollama.com/download</a></p>

<p><img src="https://www.couragesteak.com/tcos/article/30bd8e4c4e5e6ae39ae997046a8a65b0.png" alt="Ollama下载安装" /></p>

<h3><a id="21_windows_14"></a>2.1 windows安装</h3>

<p>默认安装位置:<code>C:\Users\XX\AppData\Local\Programs\Ollama</code></p>

<p>自定义安装路径</p>

<p><code>OLLAMA_MODELS</code>: D:/my/ai</p>

<h2><a id="3__22"></a>3 模型查询</h2>

<p>https://ollama.com/search</p>

<p><img src="https://www.couragesteak.com/tcos/article/43efe050421c4966d870c5fa2ea087e1.png" alt="ollama查询模型" /></p>

<h2><a id="4__28"></a>4 模型安装</h2>

<p>默认安装位置:<code>C:\Users\用户名\.ollama\models</code></p>

<h3><a id="41_deepseek_15_32"></a>4.1 deepseek 1.5</h3>

<p>启动命令,没有模型会自动下载。这里选择1.5b最小的参数。</p>

<pre><div class="hljs"><code class="lang-shell">ollama run deepseek-r1:1.5b

</code></div></pre>

<p><img src="https://www.couragesteak.com/tcos/article/edd5add180cf9c32478d1b73945f7e47.png" alt="deepseek安装" /></p>

<h2><a id="5__42"></a>5 移动模型位置</h2>

<p>(可选)先将模型手动剪切到目标为止,然后操作mklink。</p>

<pre><div class="hljs"><code class="lang-shell">mklink /J "C:\Users\Administrator\.ollama" "G:\ai\Ollama\models\.ollama"

</code></div></pre>

<p><img src="https://www.couragesteak.com/tcos/article/2000b53431d8cf2a3611568e15fce1f2.png" alt="ollama移动模型位置" /></p>

<h2><a id="6_API_52"></a>6 配置API访问</h2>

<h3><a id="61_windows_54"></a>6.1 windows配置</h3>

<h4><a id="611__56"></a>6.1.1 添加环境变量</h4>

<pre><div class="hljs"><code class="lang-shell">OLLAMA_MODELS:G:\ai\Ollama

OLLAMA_HOST:0.0.0.0

OLLAMA_ORIGINS:*

</code></div></pre>

<h4><a id="612__65"></a>6.1.2 配置防火墙</h4>

<pre><div class="hljs"><code class="lang-shell">控制面板\系统和安全\Windows Defender 防火墙

</code></div></pre>

<p>高级设置->入站规则->新建规则->端口->下一步->TCP:11434->下一步->允许连接->下一步到命名</p>

<pre><div class="hljs"><code class="lang-shell">Allow Ollama Port 11434

</code></div></pre>

<p>检查进程</p>

<pre><div class="hljs"><code class="lang-shell">netstat -aon|findstr 11434

</code></div></pre>

<h3><a id="62_CentOS_85"></a>6.2 CentOS</h3>

<p>Ollama的配置文件通常位于/etc/ollama/ollama.conf</p>

<pre><div class="hljs"><code class="lang-shell">listen_address = 0.0.0.0

</code></div></pre>

<h2><a id="7__95"></a>7 常用命令</h2>

<pre><div class="hljs"><code class="lang-shell">ollama serve 启动ollama

ollama create 从模型文件创建模型

ollama show 显示模型信息

ollama run 运行模型

ollama pull 从注册表中拉取模型

ollama push 将模型推送到注册表

ollama list 列出模型

ollama cp 复制模型

ollama rm 删除模型

ollama help 获取有关任何命令的帮助信息

</code></div></pre>

<h3><a id="_110"></a></h3>

<pre><div class="hljs"><code class="lang-shell">curl http://192.168.56.1:11434/api/generate -d '{

"model": "deepseek-r1:1.5b",

"prompt": "为什么草是绿的?"

}'

</code></div></pre>

<p>windows</p>

<p>https://curl.se/windows/</p>

<pre><div class="hljs"><code class="lang-shell">curl http://localhost:11434/api/generate -d "{\"model\": \"deepseek-r1:1.5b\", \"prompt\": \"为什么草是绿的\"}"

</code></div></pre>

评论区