torch机器学习GPU信息查看

有勇气的牛排

466

AI大模型

2025-07-22 22:16:58

1 查看GPU版本

1.1 Win

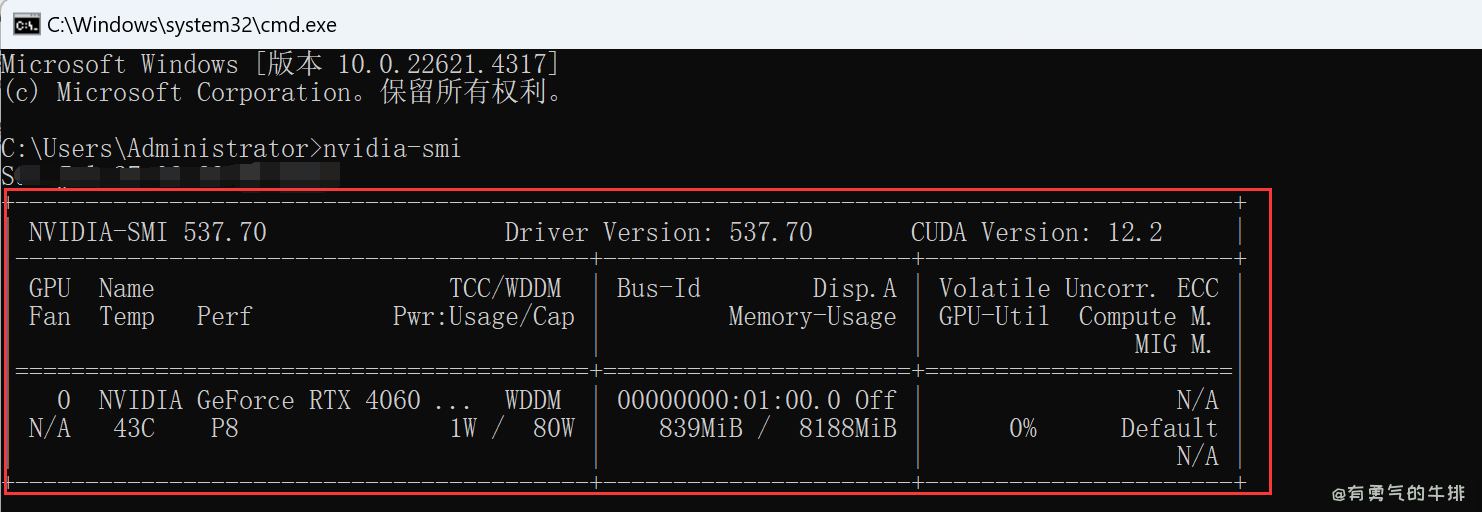

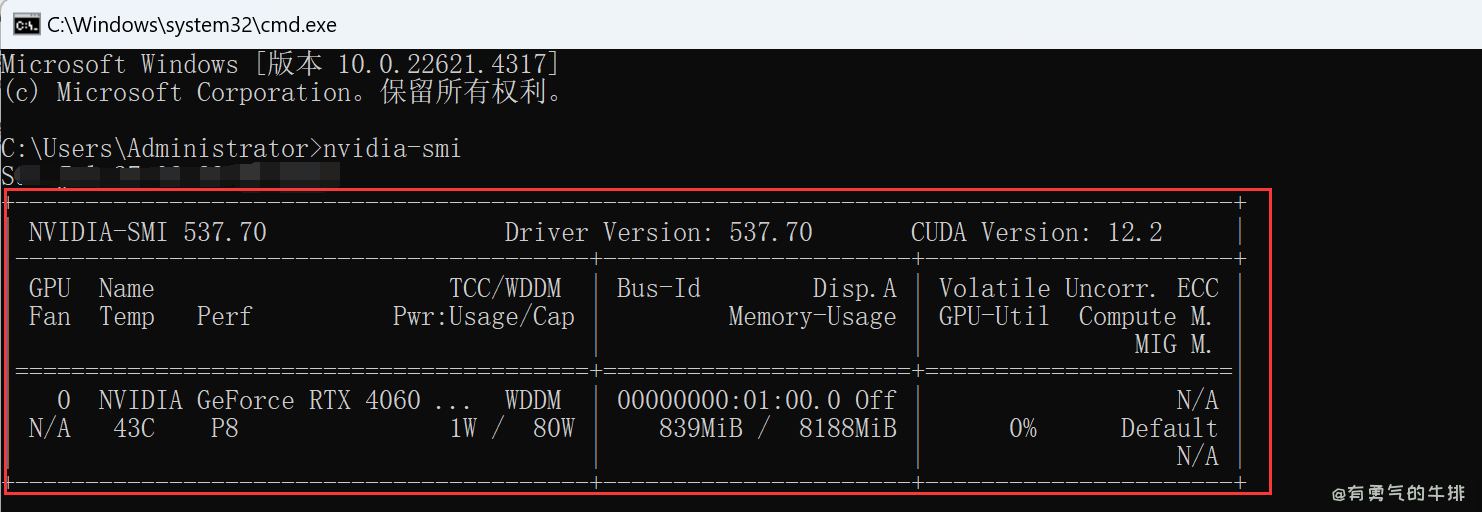

1.1.1 使用命令行 nvidia-smi(推荐)

按下 Win + R,输入 cmd 打开命令提示符。

nvidia-smi

输出案例:

+---------------------------------------------------------------------------------------+

| NVIDIA-SMI 537.70 Driver Version: 537.70 CUDA Version: 12.2 |

|-----------------------------------------+----------------------+----------------------+

| GPU Name TCC/WDDM | Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap | Memory-Usage | GPU-Util Compute M. |

| | | MIG M. |

|=========================================+======================+======================|

| 0 NVIDIA GeForce RTX 4060 ... WDDM | 00000000:01:00.0 Off | N/A |

| N/A 43C P8 1W / 80W | 839MiB / 8188MiB | 0% Default |

| | | N/A |

+-----------------------------------------+----------------------+----------------------+

1.1.2 通过 NVIDIA 控制面板查看

- 桌面右键 → 点击“NVIDIA 控制面板”。

- 进入菜单栏“帮助” → 选择“系统信息”。

- 在弹出窗口中查看“驱动版本”、“CUDA Cores”等信息。

2 安装支持 CUDA 的 PyTorch 版本

根据电脑上的 CUDA 版本,在官网选适合的命令:

官网地址:https://pytorch.org/get-started/locally/

假设 CUDA 版本是 12.2,使用以下命令:

pip install torch==2.3.1 torchvision==0.18.1+cu121 torchaudio==2.3.1+cu121 --index-url https://download.pytorch.org/whl/cu121

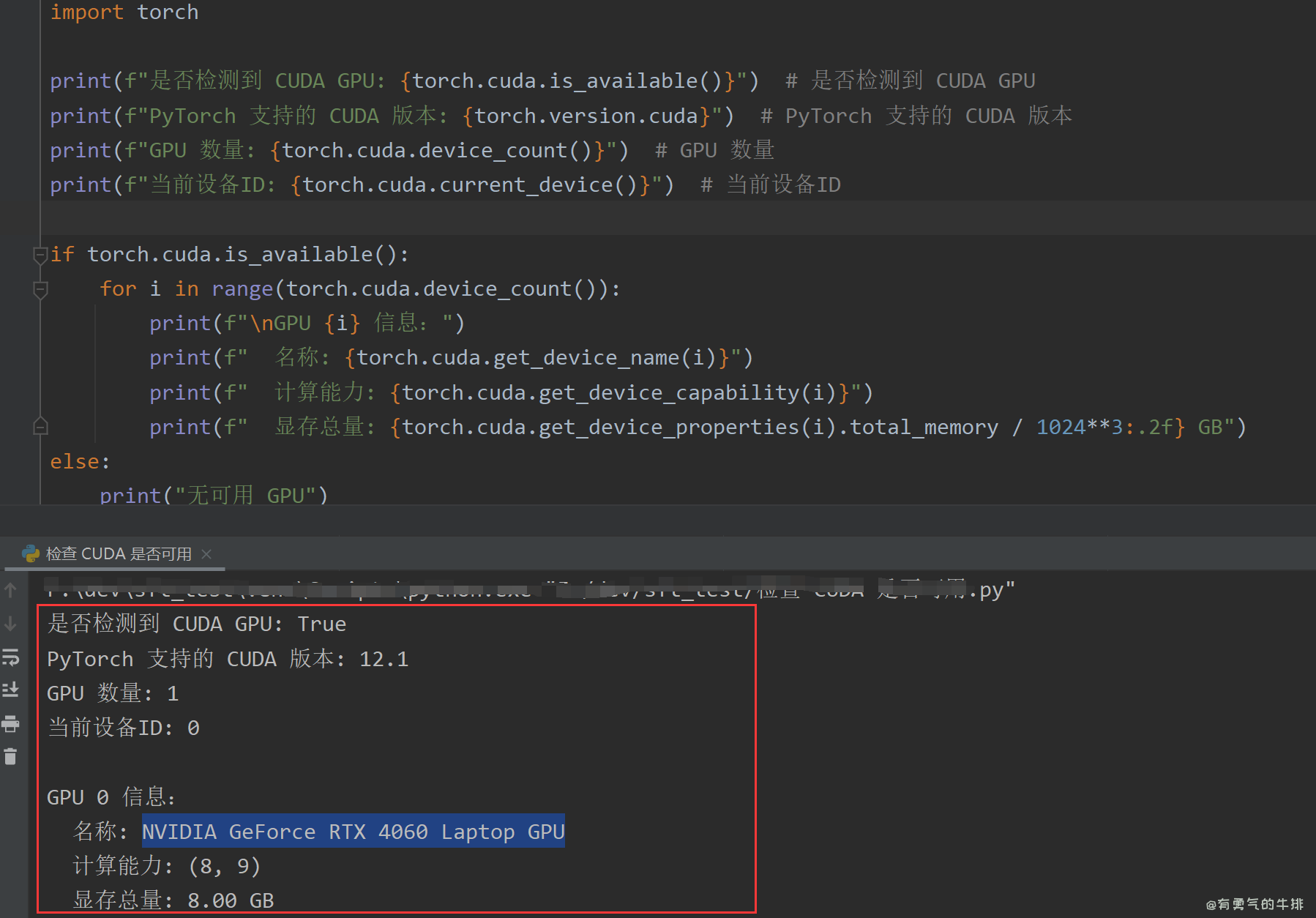

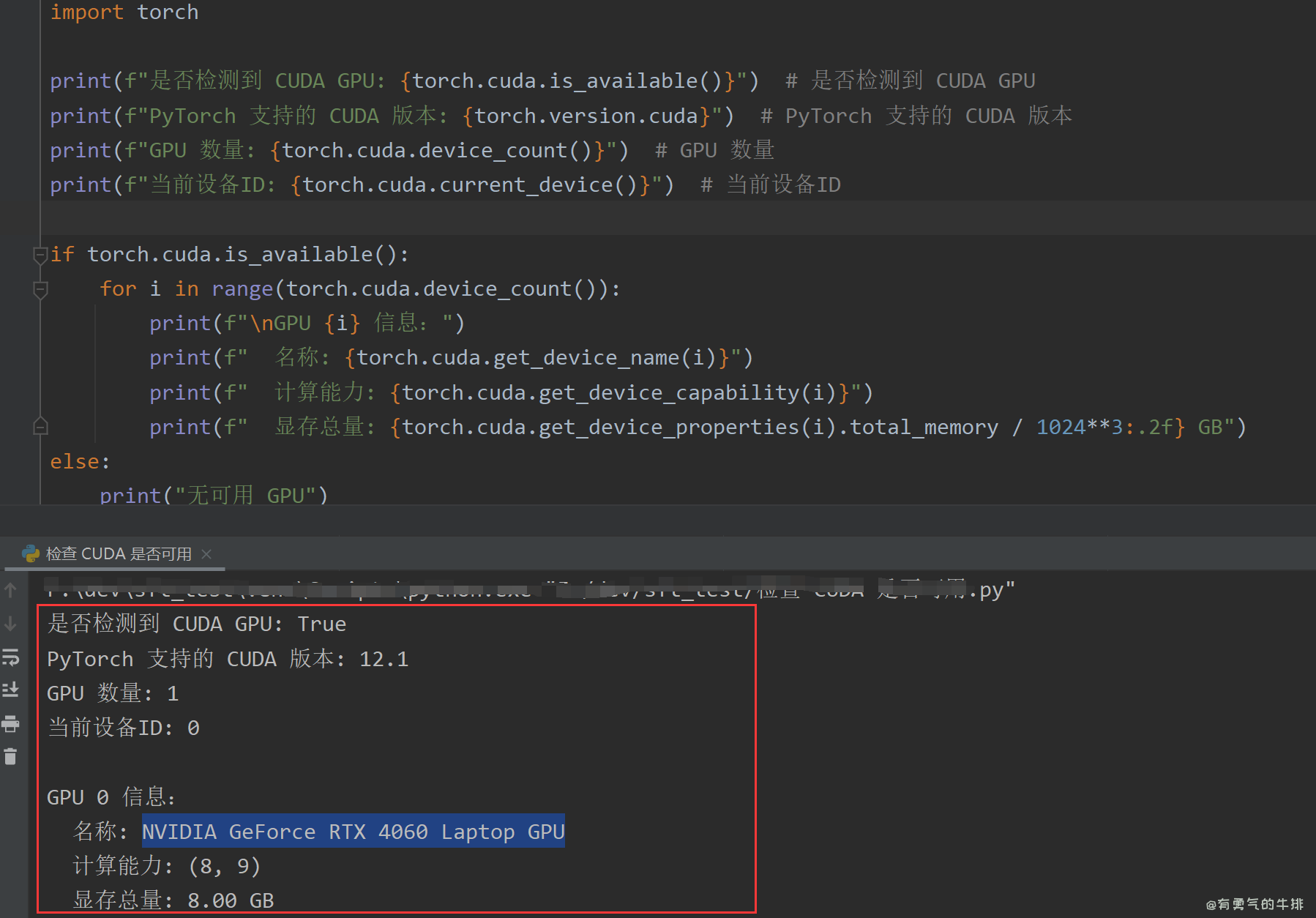

3 验证安装成功

检测脚本:

import torch

print(f"是否检测到 CUDA GPU: {torch.cuda.is_available()}")

print(f"PyTorch 支持的 CUDA 版本: {torch.version.cuda}")

print(f"GPU 数量: {torch.cuda.device_count()}")

print(f"当前设备ID: {torch.cuda.current_device()}")

if torch.cuda.is_available():

for i in range(torch.cuda.device_count()):

print(f"\nGPU {i} 信息:")

print(f" 名称: {torch.cuda.get_device_name(i)}")

print(f" 计算能力: {torch.cuda.get_device_capability(i)}")

print(f" 显存总量: {torch.cuda.get_device_properties(i).total_memory / 1024**3:.2f} GB")

else:

print("无可用 GPU")

<h2><a id="1_GPU_0"></a>1 查看GPU版本</h2>

<h3><a id="11_Win_2"></a>1.1 Win</h3>

<h4><a id="111__nvidiasmi_4"></a>1.1.1 使用命令行 <code>nvidia-smi</code>(推荐)</h4>

<p><strong>按下 Win + R</strong>,输入 <code>cmd</code> 打开命令提示符。</p>

<pre><div class="hljs"><code class="lang-shell">nvidia-smi

</code></div></pre>

<p>输出案例:</p>

<pre><div class="hljs"><code class="lang-shell">+---------------------------------------------------------------------------------------+

| NVIDIA-SMI 537.70 Driver Version: 537.70 CUDA Version: 12.2 |

|-----------------------------------------+----------------------+----------------------+

| GPU Name TCC/WDDM | Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap | Memory-Usage | GPU-Util Compute M. |

| | | MIG M. |

|=========================================+======================+======================|

| 0 NVIDIA GeForce RTX 4060 ... WDDM | 00000000:01:00.0 Off | N/A |

| N/A 43C P8 1W / 80W | 839MiB / 8188MiB | 0% Default |

| | | N/A |

+-----------------------------------------+----------------------+----------------------+

</code></div></pre>

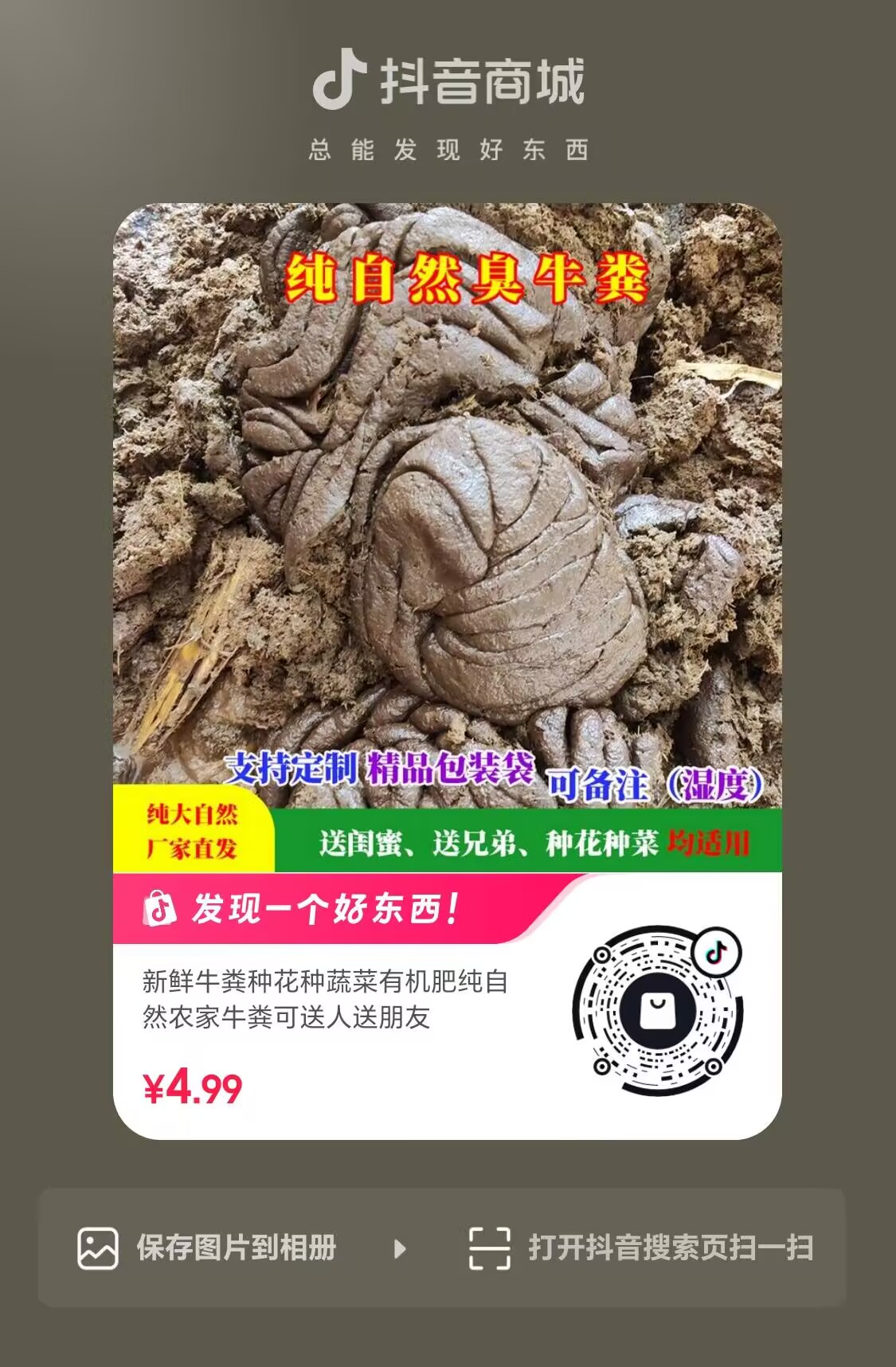

<p><img src="https://www.couragesteak.com/tcos/article/f360c5fac50a025e7baab92eb56dfc64.png" alt="Windows查看GPU信息" /></p>

<h4><a id="112__NVIDIA__30"></a>1.1.2 通过 NVIDIA 控制面板查看</h4>

<ol>

<li>桌面右键 → 点击“NVIDIA 控制面板”。</li>

<li>进入菜单栏“帮助” → 选择“系统信息”。</li>

<li>在弹出窗口中查看“驱动版本”、“CUDA Cores”等信息。</li>

</ol>

<h2><a id="2__CUDA__PyTorch__36"></a>2 安装支持 CUDA 的 PyTorch 版本</h2>

<p>根据电脑上的 CUDA 版本,在官网选适合的命令:</p>

<p>官网地址:https://pytorch.org/get-started/locally/</p>

<p>假设 CUDA 版本是 12.2,使用以下命令:</p>

<pre><div class="hljs"><code class="lang-shell">pip install torch==2.3.1 torchvision==0.18.1+cu121 torchaudio==2.3.1+cu121 --index-url https://download.pytorch.org/whl/cu121

</code></div></pre>

<h2><a id="3__48"></a>3 验证安装成功</h2>

<p>检测脚本:</p>

<pre><div class="hljs"><code class="lang-python"><span class="hljs-keyword">import</span> torch

<span class="hljs-built_in">print</span>(<span class="hljs-string">f"是否检测到 CUDA GPU: <span class="hljs-subst">{torch.cuda.is_available()}</span>"</span>) <span class="hljs-comment"># 是否检测到 CUDA GPU</span>

<span class="hljs-built_in">print</span>(<span class="hljs-string">f"PyTorch 支持的 CUDA 版本: <span class="hljs-subst">{torch.version.cuda}</span>"</span>) <span class="hljs-comment"># PyTorch 支持的 CUDA 版本</span>

<span class="hljs-built_in">print</span>(<span class="hljs-string">f"GPU 数量: <span class="hljs-subst">{torch.cuda.device_count()}</span>"</span>) <span class="hljs-comment"># GPU 数量</span>

<span class="hljs-built_in">print</span>(<span class="hljs-string">f"当前设备ID: <span class="hljs-subst">{torch.cuda.current_device()}</span>"</span>) <span class="hljs-comment"># 当前设备ID</span>

<span class="hljs-keyword">if</span> torch.cuda.is_available():

<span class="hljs-keyword">for</span> i <span class="hljs-keyword">in</span> <span class="hljs-built_in">range</span>(torch.cuda.device_count()):

<span class="hljs-built_in">print</span>(<span class="hljs-string">f"\nGPU <span class="hljs-subst">{i}</span> 信息:"</span>)

<span class="hljs-built_in">print</span>(<span class="hljs-string">f" 名称: <span class="hljs-subst">{torch.cuda.get_device_name(i)}</span>"</span>)

<span class="hljs-built_in">print</span>(<span class="hljs-string">f" 计算能力: <span class="hljs-subst">{torch.cuda.get_device_capability(i)}</span>"</span>)

<span class="hljs-built_in">print</span>(<span class="hljs-string">f" 显存总量: <span class="hljs-subst">{torch.cuda.get_device_properties(i).total_memory / <span class="hljs-number">1024</span>**<span class="hljs-number">3</span>:<span class="hljs-number">.2</span>f}</span> GB"</span>)

<span class="hljs-keyword">else</span>:

<span class="hljs-built_in">print</span>(<span class="hljs-string">"无可用 GPU"</span>)

</code></div></pre>

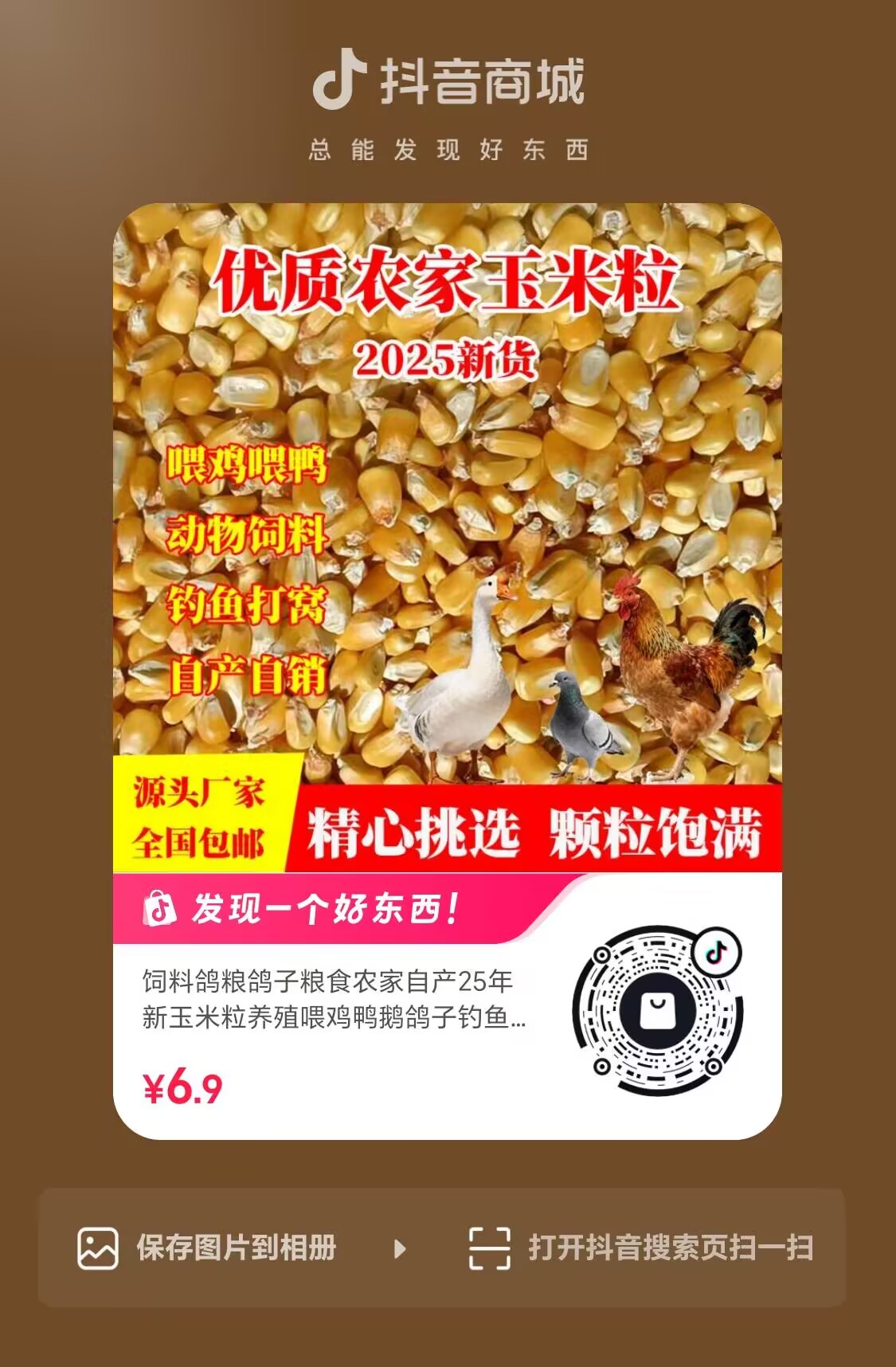

<p><img src="https://www.couragesteak.com/tcos/article/5709a8b3220925d68159552a3df6faca.png" alt="python脚本查看GPU CUDA版本信息" /></p>

评论区